在当今数字化经济时代,系统并发处理能力已成为衡量技术架构先进性的核心指标之一。

TPS(Transactions Per Second,每秒事务处理量)突破6万并发不仅是技术能力的体现,更是支撑业务快速增长的基础保障。

从电商大促到金融交易,从社交网络到物联网平台,高并发场景无处不在。

如何构建能够稳定支撑6万以上TPS的系统架构,成为众多技术团队面临的重大挑战。

多级缓存架构设计

合理的缓存策略,可将90%以上的请求拦截在数据库之外。

比如:利用HTTP缓存头(Cache-Control、ETag)和Service Worker,减少30-40%的重复请求。

CDN边缘缓存

静态资源通过CDN分发,全球平均访问延迟可控制在50ms以内。

比如:阿里云CDN在全球拥有无数的节点,支撑过双11的“数亿”QPS峰值。

应用层缓存

本地缓存、与分布式缓存(Redis)配合使用,命中率可达95%+。

比如:Caffeine(堆内,100ms级)→ Redis(分布式,10ms级)→ 数据库。

Redis集群优化实践

Redis作为高并发系统的核心组件,其配置优化直接影响整体性能:

根据数据规模选择Codis、Redis Cluster或Proxy方案,某电商平台采用Redis Cluster(32分片)支撑了12万/秒的订单查询。

String类型适合简单KV,Hash适合对象存储,Sorted Set适合排行榜场景,错误的数据结构选择可能导致10倍以上的性能差异。

持久化策略

RDB+AOF混合模式在性能与可靠性间取得平衡,fsync配置为everysec时性能损失约2%,但可保证最多1秒数据丢失。

热点Key处理

通过本地缓存+Redis多副本分散热点,某直播平台通过此方案解决了价值千万的热门直播间卡顿问题。

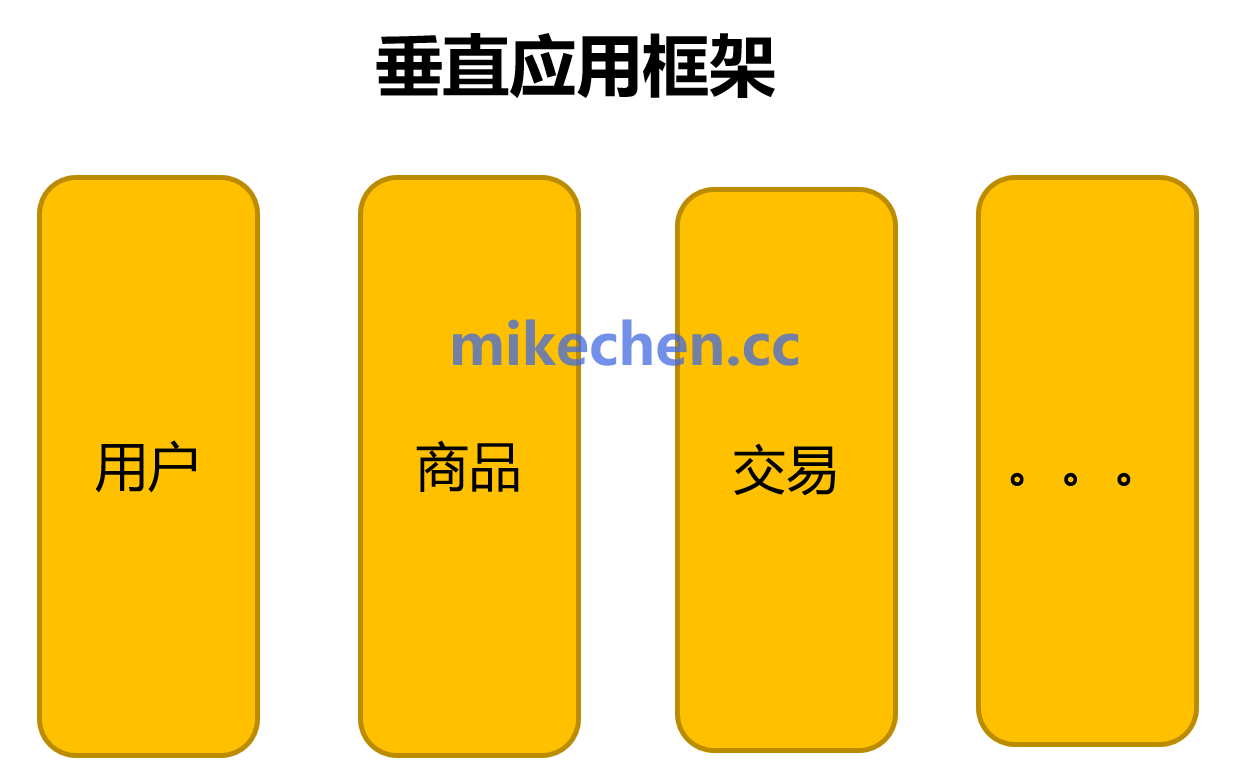

分布式架构

微服务架构通过业务解耦和水平扩展能力,为高并发场景提供了理想的架构基础。

按照业务领域进行垂直拆分,确保每个微服务处理单一业务功能。

例如:

-

用户服务:管理用户注册、登录、认证。

-

商品服务:管理商品信息、库存、价格。

-

订单服务:处理订单创建、查询、取消等。

-

支付服务:对接支付渠道(支付宝、微信、Stripe 等)。

-

物流服务:负责订单配送、状态跟踪。

每个微服务拥有独立数据库,避免多个微服务竞争同一个数据库锁,提高并发能力。

采用数据库表按业务拆分,例如:

用户服务 只存储用户信息表 users;

订单服务 只存储订单表 orders;

商品服务 只存储商品表 products。

在高并发场景下,不同的业务压力不同,因此需要独立扩展不同的微服务:

| 服务名称 | 典型QPS | 高峰期扩展策略 |

|---|---|---|

| 用户服务 | 1k QPS | 2-3 倍扩容 |

| 商品服务 | 5k QPS | 10 倍扩容 |

| 订单服务 | 2k QPS | 4-5 倍扩容 |

| 支付服务 | 500 QPS | 2 倍扩容 |

| 物流服务 | 300 QPS | 1.5 倍扩容 |

容错设计

通过熔断(如Hystrix)、降级和限流机制,确保单个服务的故障不会扩散到整个系统。

某电商平台在采用微服务架构后,系统容错能力提升300%,大促期间故障率降低至0.001%。

异步事件驱动架构

同步阻塞是限制系统并发能力的主要因素之一,异步化改造可显著提升系统吞吐量。

将非实时性业务逻辑异步化,如订单创建后的积分计算、物流通知等。

1. 订单创建(核心逻辑,必须同步返回) 2. 订单成功后: - 计算积分(可异步) - 发送物流通知(可异步) - 发送短信通知(可异步)

在电商场景下,典型的非实时性业务包括:

-

积分计算:订单支付成功后,积分系统异步计算并更新用户积分。

-

物流通知:订单发货后,异步通知物流系统,避免影响主流程响应时间。

-

邮件/短信推送:下单成功、订单发货后,异步发送通知,减少接口调用阻塞。

无状态设计与水平扩展

有状态服务是限制系统扩展性的主要障碍,无状态化设计可最大化利用集群能力:

将会话信息存储在Redis等外部缓存而非应用内存,某社交平台通过此改造将会话管理性能提升400%。

采用一致性哈希算法或加权轮询策略,确保流量在集群中均匀分布。

数据库优化策略

在高并发系统中,数据库是最容易成为瓶颈的地方。

因此,按照用户ID哈希、时间范围、地域等维度进行数据库拆分,可以有效降低单库压力,提高系统吞吐量。

比如:某社交平台按用户ID尾号分64库,每个库再分16表,支撑了1.2亿日活用户。

CREATE TABLE user_0 ( id BIGINT PRIMARY KEY, name VARCHAR(255), email VARCHAR(255) ) PARTITION BY HASH (id);

例如:

-

user_id % 64→ 64 个库; -

user_id % 16→ 16 个表;

索引优化

只建立必要的索引,避免索引过多导致写入变慢。

比如:通过EXPLAIN识别全表扫描、临时表等性能杀手。

某ERP系统,通过优化20个关键SQL,整体查询性能提升8倍。

应用层优化(针对Java体系)

GC策略选择:高并发服务推荐G1或ZGC,相比CMS可减少90%的STW时间。某交易系统升级到JDK17+ZGC后,GC停顿从200ms降至10ms以内。

堆内存配置:-Xmx设为可用内存的70-80%,新生代与老年代比例建议1:2。过大的堆反而会导致GC效率下降。

JIT优化:-XX:+TieredCompilation启用分层编译,-XX:CICompilerCount设为CPU核数的1/4到1/2。

操作系统与网络优化

文件描述符限制:设置ulimit -n至少为65535。

TCP参数调优:net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_max_syn_backlog = 16384

net.core.somaxconn = 32768

读写优化

除此之外,不同的业务场景对 TPS 的要求、和瓶颈点不同。

例如,读多写少的场景和写多读少的场景,可以根据不同的情况来优化。

陈睿mikechen

10年+大厂架构经验,资深技术专家,就职于阿里巴巴、淘宝、百度等一线互联网大厂。

关注作者「mikechen」公众号,获取更多技术干货!

后台回复【架构】,即可获取《阿里架构师进阶专题全部合集》,后台回复【面试】即可获取《史上最全阿里Java面试题总结》